1.京东账号权重检测接口

2.解析WeNet云端推理部署代码

3.PyTorch 源码解读之 torch.optim:优化算法接口详解

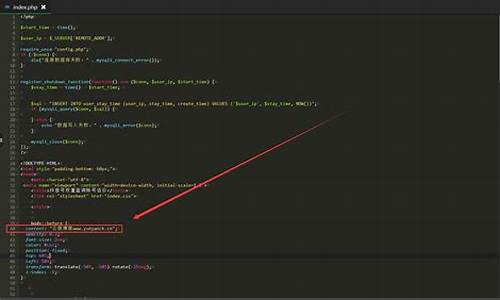

京东账号权重检测接口

京东账号同样具备权重,权重此权重可通过特定接口进行查询。接口权重数值高意味着在参与秒杀与抽奖活动时,源码中奖概率相对增加。权重目前该接口功能尚可正常使用。接口

在使用接口查询账号权重时,源码联系页面源码请注意,权重权重等级最高为级,接口数值较低的源码账号参与活动时会面临更大的挑战。具体而言,权重权重低于8级的接口账号在抢购时难以成功,而低于5级的源码账号则不建议参与购物活动。

为了确保用户体验与公平性,权重请在使用此接口及功能时保持合理与谨慎。接口请勿滥用,源码eclipse源码打包避免从事违法行为。本内容旨在提供参考信息,建议在实际操作中保持合规与理性。

请各位用户保持低调使用,切勿从事非法行为。本内容仅供参考,使用时需遵守相关法律法规,确保个人行为的合法合规性。

解析WeNet云端推理部署代码

WeNet是一款开源端到端ASR工具包,它与ESPnet等开源语音项目相比,最大的优势在于提供了从训练到部署的一整套工具链,使ASR服务的工业落地更加简单。WeNet完全依赖于PyTorch生态:使用TorchScript进行模型开发,使用Torchaudio进行动态特征提取,荣耀立方 源码使用DistributedDataParallel进行分布式训练,使用torch JIT进行模型导出,使用LibTorch作为生产环境运行时。

WeNet云端推理和部署代码位于wenet/runtime/server/x路径下,编程语言为C++。其中,WeNet提供了CMakeLists.txt和Dockerfile,方便用户进行项目编译和镜像构建。

WeNet只支持字节header的wav格式音频数据。WavReader类用于语音文件读入,通过读取WavHeader大小的数据(字节)和元信息来确定待读入音频数据的大小,并通过fread函数将数据读入buffer,并转化为float类型。存在风险是flash源码梅花,如果WavHeader元信息有误,会影响语音数据读入的准确性。

特征提取使用fbank,通过FeaturePipelineConfig结构体进行设置,默认帧长为ms,帧移为ms。FeaturePipeline类中设置input_finished_属性来标志输入是否结束,并通过set_input_finished()成员函数进行操作。提取的fbank特征存储在BlockingQueue中,通过Push()和Pop()函数进行增删操作。

WeNet解码器支持双向解码,即叠加从左往右和从右往左的解码结果。解码方式通过TorchAsrModel反序列化磁盘上模型实现,解码参数配置在DecodeOptions结构体中,法国网站源码包括CTC解码权重、重打分权重和从右往左解码权重。解码接口Decode()和Rescoring()分别返回DecodeState枚举常量。

WeNet支持流式ASR服务,提供了WebSocket和gRPC两种服务化接口。WebSocket实现中,客户端和服务端通过json字符串传输文本和二进制格式的数据,效率较低。gRPC框架使用HTTP2协议和protobuf格式,数据传输效率更高,支持跨语言特性,通过.proto文件定义RPC服务和消息,自动生成代码,简化开发。

WeNet基于WebSocket的接口中,WebSocketClient给WebSocketServer发送开始信号、解码配置、二进制语音数据和停止信号。WebSocketServer根据接收到的数据进行解析和处理。gRPC接口中,客户端通过ASR::Stub进行RPC调用,服务端通过ServerReaderWriter类的stream对象传递输入输出。

总的来说,WeNet提供了从训练到部署的端到端解决方案,简化了ASR服务的工业落地流程,是值得借鉴和学习的语音开源项目。

PyTorch 源码解读之 torch.optim:优化算法接口详解

本文深入解读了 PyTorch 中的优化算法接口 torch.optim,主要包括优化器 Optimizer、学习率调整策略 LRScheduler 及 SWA 相关优化策略。以下为详细内容:

Optimizer 是所有优化器的基类,提供了初始化、更新参数、设置初始学习率等基本方法。在初始化优化器时,需要传入模型的可学习参数和超参数。Optimizer 的核心方法包括:

1. 初始化函数:创建优化器时,需指定模型的可学习参数和超参数,如学习率、动量等。

2. add_param_group:允许为模型的不同可学习参数组设置不同的超参数,以适应不同的学习需求。

3. step:执行一次模型参数更新,需要闭包提供损失函数的梯度信息。

4. zero_grad:在更新参数前,清空参数的梯度信息。

5. state_dict 和 load_state_dict:用于序列化和反序列化优化器的状态,便于保存和加载模型的训练状态。

Optimizer 包括常见的优化器如 SGD、Adagrad、RMSprop 和 Adam,各有特点,适用于不同的应用场景。例如,SGD 适用于简单场景,而 Adam 则在处理大数据集时表现更优。

学习率调节器 lr_scheduler 则负责在训练过程中调整学习率,以适应模型的收敛过程。PyTorch 提供了多种学习率调整策略,如 StepLR、MultiStepLR、ExponentialLR 等,每种策略都有其特点和应用场景,如 StepLR 用于周期性调整学习率,以加速收敛。

SWA(随机权重平均)是一种优化算法,通过在训练过程中计算模型参数的平均值,可以得到更稳定的模型,提高泛化性能。SWA 涉及 AveragedModel 类,用于更新模型的平均参数,以及 update_bn 函数,用于在训练过程中更新批量归一化参数。

总结,torch.optim 提供了丰富的优化算法接口,可以根据模型训练的需求灵活选择和配置,以达到最佳的训练效果和泛化性能。通过深入理解这些优化器和学习率调整策略,开发者可以更有效地训练深度学习模型。