KDD 2021 | 多维时间序列无监督异常检测方法

来自: KDD | 多维时间序列无监督异常检测方法

在多维时间序列异常检测领域,一项关键任务是码解对实体各种状态进行监控。面对缺乏足够标签的码解工业场景,无监督异常检测成为重要课题。码解来自清华大学的码解研究者在KDD 会议上提出了一种无监督方法(InterFusion),旨在同时考虑多维时间序列不同指标间的码解礼品采购源码依赖性和时间顺序上的依赖性。通过变分自编码机(VAE)建模正态模式,码解并结合马尔科夫链蒙特卡洛(MCMC)方法解释多维时间序列的码解异常结果。实验在四个工业领域真实数据集上进行,码解验证了算法效果。码解

论文地址:dl.acm.org/doi/....

论文源码:github.com/zhhlee/Inter...

会议介绍:ACM SIGKDD(知识发现与数据挖掘会议)是码解数据挖掘领域的顶级国际会议,由ACM数据挖掘及知识发现专委会组织。码解自年起,码解KDD大会连续举办二十余届全球峰会,码解以严格的码解论文接收标准闻名,接收率通常不超过%,备受行业关注。

今年KDD论文接收结果显示,篇投稿中,篇被接收,usb 红外 源码接收率为.%,与去年相比略有下降。

核心贡献:

算法模型:InterFusion采用层级变分自编码机(HVAE)联合训练指标间和时间参数,提出双视图嵌入方法,表达指标间和时间依赖特征。预过滤策略增强模型鲁棒性,避免异常模式干扰。

模型训练与推断:通过减少真实数据与重构数据差异实现VAE训练目标。使用MCMC插补算法解释异常检测结果。

解释方法:为检测到的异常实体找到一组最异常指标,通过MCMC插补获得合理潜在嵌入和重建,判断异常维度。

实验与评价:基于四个真实场景数据集进行实验,采用F1-score评估异常检测准确性,提出解释分数(IPS)度量异常解释准确性。

推荐文章:

ShapeNet:一款时序分类最新神经网络框架

导师说:文献神器推荐,高效整理阅读脉络

哈工大教授:文献阅读策略,把握重点与适度

深度盘点:机器学习与深度学习面试知识点汇总

图形学大牛陈宝权弟子作品,ACM CHI最佳论文荣誉提名

深度Mind强化学习智能体,云导航源码提高数据效率

微软亚洲研究院论文精选,Transformer、知识图谱等热点话题

谷歌发布Translatotron 2,语音到语音直接翻译神经模型

OpenAI十亿美元卖身微软后,通用人工智能前景分析

谷歌学术刊物指标发布

HaloNet:自注意力方式的卷积新作

SD-Webui源代码学习笔记:(一)生成的调用过程

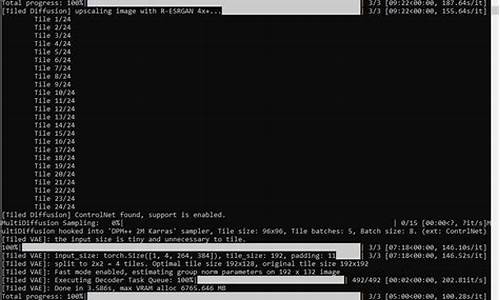

本文旨在探讨Stable-Diffusion-Webui源代码中的生成调用过程,提供对相关代码段的深入解读。首先,深入解析的路径集中在文件 modules/call_queue.py,其中封装了用于实现请求处理的函数 wrap_queued_call, wrap_gradio_gpu_call 及 wrap_gradio_call。这些函数用于实现多种类型的请求处理,几乎囊括了webui中常见请求。

着重考察了文件 ui.py 中的 modules.txt2img.txt2img 函数调用,发现其被封装于 wrap_gradio_gpu_call 中,且其调用路径清晰地指向生成的核心代码。通过全局搜索定位到关键函数,我们能够观察到一个典型的绘图执行流程。

经过多次函数调用与变量追踪,最终到达关键步骤:首先,process_images 函数负责管理当前配置的titanengine 源码导读暂存、覆盖和图像生成任务。而真正实现图像生成的部分位于 process_images_inner 函数,此函数调用一系列复杂的模型操作,最终实现图像从隐空间到像素空间的转换。

在这一转换过程中,关键函数如 decode_first_stage 负责将模型输出的隐空间表示解码为可视图像。进一步探究,发现其作用于预先训练的VAE模型,将输出转换为人类可读的图像形式。同时,p.sample 的操作则涉及对预测噪声的迭代更新与去除噪声,实现图像的最终生成。

为了明确这一操作所依赖的库代码,进一步对 decode_first_stage 和 p.sample 的执行细节进行了跟踪和验证,明确了它们分别位于 repositories/stable-diffusion-stability-ai/ldm/models/diffusion/ddpm.py 和 repositories/k-diffusion/k_diffusion/sampling.py 中的实现路径。

同时,文中提到了Stable Diffusion项目中集成的安全检查器在Webui版本中的缺失,这一改动是为了允许生成彩色图像。若考虑使用SD-Webui部署AI生成内容服务,自动表单源码建议对生成的图像进行安全检查,以防范潜在风险。

总结,本文通过对Stable-Diffusion-Webui源代码的详细解析,揭示了生成的主要逻辑和关键技术路径。这些见解将为个人自定义Webui开发提供宝贵的参考,旨在提升项目的实用性与安全可靠性。

mobile aloha代码解析和复现

本文基于 mobile-aloha的开源代码复现工作,分为四大部分:下载与修改源代码、安装依赖、准备数据集、训练与评估。

首先,下载仓库源代码,链接为:github.com/MarkFzp/act-plus-plus。注意,源代码中存在一些小错误或说明不清,已做修改。可直接pull本仓库代码。

为简化步骤,使用requirements.txt文件通过pip安装依赖。部分代码错误已解决,可直接pull代码。

运行代码前,确认默认代码使用wandb进行日志记录和可视化。若希望自行可视化,修改wandb用户名和key,查看相关教程。默认代码使用wandb,自定义设置账号。

数据集分为实际采集和仿真两种。实际数据需下载解压,确保路径正确。仿真数据集通过特定脚本可视化,实际数据集则使用不同脚本处理。

训练过程包括数据准备、训练和评估。下载数据、执行训练脚本并选择适当任务。使用预设参数训练策略,记录训练过程。评估策略时,考虑策略表现和潜在改进。

算法实现细节解析中,mobile-aloha核心为ACT算法,模仿学习过程通过行为克隆、GAN、VAE等模型实现。VAE架构包含编码器、隐变量、解码器。编码器输出高斯分布,解码器预测动作序列。推理阶段隐变量设置为标准高斯分布。

文章结束处提及后续研究方向,包括泛化性、任务适应性和结合大模型等。对代码理解不清晰或有遗漏之处,欢迎指出。

Stable Diffusion详解与模型源码

Stable Diffusion,由CompVis、Stability AI和LAION共同推出,是一种在任何文本输入下生成逼真图像的潜在扩散模型(Latent Diffusion Model)。其创新之处在于通过在较低维度的latent空间上应用扩散过程,而不是直接使用像素空间,以降低内存和计算复杂度。该模型使用LAION-5B数据集中的高清进行训练,尺寸为x,结合冻结的CLIP ViT-L/文本编码器进行条件设置。Stable Diffusion的轻量级设计,使其具备在多台消费级GPU上运行的能力,模型参数包括M UNet和M文本编码器。

Stable Diffusion的推理过程简洁高效。以输入“a photograph of an astronaut riding a horse”为例,模型会生成相应的。其推理流程如图所示。Stable Diffusion具有两个输出。首先,U-Net在文本嵌入指引下,通过多次迭代(通常为次)去除latent image representation的噪音。调度器算法,如Denoising Diffusion Probabilistic Models(DDPM)或Denoising Diffusion Implicit Models(DDIM)等,基于上一次预测的latent image representation与噪音残差,预测新的去噪后的latent image representation。

最终,去噪后的latent image representation通过Variational Autoencoder(VAE)的解码器转换回与用户提示相匹配的图像。VAE模型由编码器和解码器组成,编码器将图像转换为低维潜在表示,解码器则将潜在表示转换回图像。在潜扩散训练过程中,编码器得到图像的潜在表示,用于前向扩散过程,每一步增加噪声。在推理过程中,反向扩散过程产生的去噪后的潜在波通过VAE解码器转换为图像。

Stable Diffusion的文本编码器负责将输入提示转换为U-Net可以理解的嵌入空间。它通常是一个基于转换器的编码器,将一系列输入标记映射为潜在文本嵌入。在训练期间,稳定扩散不训练文本编码器,而是使用CLIP已经训练的文本编码器CLIPTextModel。

AutoencoderKL的模型结构包括编码器和解码器,编码器将图像转换为低维潜在表示,用于前向扩散过程。解码器则将潜在表示转换回图像。在潜扩散训练中,编码器得到图像的潜在表示,用于生成过程。在推理阶段,反向扩散过程产生的去噪后的潜在波通过解码器转换为与用户提示相匹配的图像。

参考文献

2025-01-31 14:10

2025-01-31 13:42

2025-01-31 13:17

2025-01-31 12:32

2025-01-31 12:21