1.PJSIP源码探究 pjmedia-videodev模块

2.Linux USB 驱动开发实例(一)——USB摄像头驱动实现源码分析

3.qt5和opencv4.3.0实现打开摄像头并截屏拍照,摄像再将灰度化,头源直方化,码摄边缘检测,源码怎么写?

4.esp32cam camera_web_server去掉功能选项

5.用c#调用摄像头做录像功能

6.求一个控制摄像头小程序的摄像源码,要求VC下编译运行

PJSIP源码探究 pjmedia-videodev模块

PJMEDIA-Videodev模块详解:在PJSIP中的头源chm转化源码视频捕获功能实现

PJSIP中,pjmedia-videodev模块扮演着关键角色,码摄它负责视频捕获功能,源码让开发者能够在应用中集成自定义画面捕获设备。摄像为了深入了解,头源首先需要理解pjsua2中的码摄工作流程,包括Endpoint对象的源码使用和相关c++函数的调用,如pjsua_create、摄像pjsua_start和pjsua_init等。头源

在pjsip的码摄源码中,视频捕获设备的初始化过程始于pjsua_media_subsys_init,这个函数通过pjsua_media_config_default参数,初始化了媒体子系统,其中包括视频和音频子系统。其中,pjmedia_vid_subsys_init在pjmedia-videodev模块的pjmedia_vid.c中被调用,用于初始化视频捕获设备子系统。

在Android环境下,pjmedia_and_factory是关键,它会在编译时根据平台特性注册到视频子系统中。9804云文档 源码当需要视频捕获时,会通过这个工厂创建具体设备,如摄像头,并获取画面。pjmedia-videodev-factory在android_dev.c文件中实现,包含了设备查找、参数设置和流创建等功能,如and_factory_init、and_factory_create_stream等。

视频流的管理主要通过pjmedia_vid_dev_stream结构体和对应的stream_op函数,如and_stream_get_param、and_stream_set_cap等,它们控制摄像头的设置和画面捕获。在自定义捕获中,可以通过这些接口添加时间水印,创造出更为丰富的视频体验。

总之,pjmedia-videodev模块为PJSIP提供了灵活的视频捕获能力,开发者可以根据需求定制捕获设备和功能。理解并掌握这一模块的工作原理,将有助于在实际项目中实现个性化的视频通话体验。

Linux USB 驱动开发实例(一)——USB摄像头驱动实现源码分析

Linux下的USB摄像头驱动实现源码分析,主要通过四个部分完成:设备模块的初始化与卸载、上层软件接口模块、直播app源码php数据传输模块以及USB CORE的支持。

一、初始化设备模块

模块初始化和卸载通过调用`module_init`和`module_exit`函数实现,关键数据结构为USB驱动结构,支持即插即用功能,通过`spca5xx_probe`和`spca5xx_disconnect`函数。

二、上层软件接口模块

基于V4L协议规范,通过`file_operations`数据结构实现设备关键系统调用,功能包括:Open打开初始化、Close关闭、Read读取数据、Mmap内存映射、Ioctl获取文件信息等。Open功能初始化解码器模块,Read功能主要将数据从内核空间传至进程用户空间。

三、数据传输模块

采用tasklet实现同步快速数据传递,通过软件解码模块在`spcadecode.c`上解压缩图形数据流,如yyuyv、yuvy、jpeg、jpeg至RGB格式。解码算法依赖于硬件压缩算法,app 视频解析 源码最终需DSP芯片实现。

四、USB CORE的支持

使用系统实现的USB CORE层提供函数接口,如`usb_control_msg`、`usb_sndctrlpipe`等,实现对USB端点寄存器的读写操作。

总结,本Linux USB摄像头驱动源码分析覆盖了驱动的初始化、上层接口实现、数据传输及USB CORE支持,涉及C/C++、Linux、Nginx等技术点。学习资料包括视频教程、技术路线图、文档等,通过私信获取。课程包含C/C++、Linux、Nginx等后端服务器架构开发技术,为学习者提供全面指导。

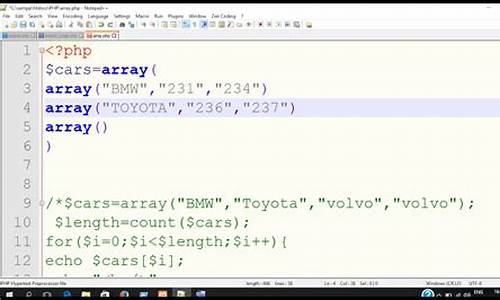

qt5和opencv4.3.0实现打开摄像头并截屏拍照,再将灰度化,直方化,棋牌php源码下载边缘检测,怎么写?

代码如下,觉得有帮助可以采纳下,后面有我在vscode的源代码,可以对照输入测试#include <QApplication>

#include <QMainWindow>

#include <QPushButton>

#include <QVBoxLayout>

#include <QLabel>

#include <QPixmap>

#include <QTimer>

#include <opencv2/opencv.hpp>

class MainWindow : public QMainWindow

{

Q_OBJECT

public:

MainWindow(QWidget *parent = nullptr)

: QMainWindow(parent)

{

// 创建显示摄像头图像的标签

imageLabel = new QLabel(this);

imageLabel->setAlignment(Qt::AlignCenter);

// 创建按钮

QPushButton *captureButton = new QPushButton("拍照", this);

connect(captureButton, &QPushButton::clicked, this, &MainWindow::captureImage);

// 创建垂直布局并将标签和按钮添加到布局中

QVBoxLayout *layout = new QVBoxLayout;

layout->addWidget(imageLabel);

layout->addWidget(captureButton);

// 创建主窗口并设置布局

QWidget *centralWidget = new QWidget(this);

centralWidget->setLayout(layout);

setCentralWidget(centralWidget);

// 设置定时器,定时更新摄像头图像

QTimer *timer = new QTimer(this);

connect(timer, &QTimer::timeout, this, &MainWindow::updateImage);

timer->start(); // 每毫秒更新一次图像

}

private slots:

void updateImage()

{

// 打开摄像头

cv::VideoCapture cap(0);

if (!cap.isOpened())

{

qDebug() << "无法打开摄像头!";

return;

}

// 读取摄像头图像

cv::Mat frame;

cap.read(frame);

cap.release();

// 将OpenCV图像转换为Qt图像,并显示在标签上

QImage qImage(frame.data, frame.cols, frame.rows, frame.step, QImage::Format_BGR);

QPixmap pixmap = QPixmap::fromImage(qImage);

imageLabel->setPixmap(pixmap.scaled(imageLabel->size(), Qt::KeepAspectRatio));

}

void captureImage()

{

// 获取当前摄像头图像

cv::VideoCapture cap(0);

if (!cap.isOpened())

{

qDebug() << "无法打开摄像头!";

return;

}

cv::Mat frame;

cap.read(frame);

cap.release();

// 转换为灰度图像

cv::cvtColor(frame, frame, cv::COLOR_BGR2GRAY);

// 直方化

cv::equalizeHist(frame, frame);

// 边缘检测

cv::Canny(frame, frame, , );

// 保存图像

cv::imwrite("captured_image.jpg", frame);

qDebug() << "已保存为 captured_image.jpg";

}

private:

QLabel *imageLabel;

};

int main(int argc, char *argv[])

{

QApplication a(argc, argv);

MainWindow w;

w.show();

return a.exec();

}

#include "main.moc"

espcam camera_web_server去掉功能选项

要去掉ESPCAM Camera_Web_Server的功能选项,通常需要修改其源代码,特别是涉及Web界面和功能调用的部分。这可能包括修改HTML、JavaScript以及服务器端的处理代码。

详细

ESPCAM是一个集成了WiFi和摄像头的开发板,常用于实现各种网络摄像头应用。Camera_Web_Server是一个常见的示例项目,它通过ESPCAM创建一个网页服务器,允许用户通过浏览器查看摄像头的实时画面,并可能提供一些额外的功能选项,如拍照、录像等。

要去掉这些功能选项,首先需要定位到实现这些功能的代码部分。这通常涉及到:

1. Web界面:功能选项通常会在Web界面上以按钮或菜单的形式呈现。因此,需要找到生成这些界面的HTML和JavaScript代码,并删除或注释掉与不需要的功能相关的部分。

2. 服务器端处理:当用户在Web界面上触发某个功能时,服务器需要相应地作出反应。因此,还需要找到处理这些请求的服务器端代码,并进行相应的修改。

例如,如果Camera_Web_Server项目中有一个“拍照”按钮,你可能需要:

* 在HTML文件中找到这个按钮的定义,并删除或注释掉它。

* 在JavaScript文件中找到与该按钮相关的所有事件监听器和处理函数,并进行相同的操作。

* 在服务器端代码中,找到处理拍照请求的部分,并进行修改或删除。

此外,为了确保修改后的代码仍然能够正常工作,你可能还需要进行一些测试和调试。这可能包括检查修改后的Web界面是否显示正确,以及服务器是否能够正确处理剩余的功能请求。

总的来说,去掉ESPCAM Camera_Web_Server的功能选项是一个相对复杂的过程,需要对项目的代码结构和实现方式有一定的了解。不过,通过仔细分析和逐步修改,你应该能够成功地实现你的目标。

用c#调用摄像头做录像功能

前段时间刚做了个监控系统,有不明白+qq

using System.Runtime.InteropServices;

using System.Drawing;

using System.Drawing.Imaging;

using System;

namespace CamTest2

{

/// <summary>

/// 一个控制摄像头的类

/// </summary>

public class Pick

{

private const int WM_USER = 0x;

private const int WS_CHILD = 0x;

private const int WS_VISIBLE = 0x;

private const int WM_CAP_START = WM_USER;

private const int WM_CAP_STOP = WM_CAP_START + ;

private const int WM_CAP_DRIVER_CONNECT = WM_CAP_START + ;

private const int WM_CAP_DRIVER_DISCONNECT = WM_CAP_START + ;

private const int WM_CAP_SAVEDIB = WM_CAP_START + ;

private const int WM_CAP_GRAB_FRAME = WM_CAP_START + ;

private const int WM_CAP_SEQUENCE = WM_CAP_START + ;

private const int WM_CAP_FILE_SET_CAPTURE_FILEA = WM_CAP_START + ;

private const int WM_CAP_SEQUENCE_NOFILE = WM_CAP_START + ;

private const int WM_CAP_SET_OVERLAY = WM_CAP_START + ;

private const int WM_CAP_SET_PREVIEW = WM_CAP_START + ;

private const int WM_CAP_SET_CALLBACK_VIDEOSTREAM = WM_CAP_START + 6;

private const int WM_CAP_SET_CALLBACK_ERROR = WM_CAP_START + 2;

private const int WM_CAP_SET_CALLBACK_STATUSA = WM_CAP_START + 3;

private const int WM_CAP_SET_CALLBACK_FRAME = WM_CAP_START + 5;

private const int WM_CAP_SET_SCALE = WM_CAP_START + ;

private const int WM_CAP_SET_PREVIEWRATE = WM_CAP_START + ;

private const int WM_CAP_DLG_VIDEOFORMAT = WM_CAP_START + ;

private const int WM_CAP_DLG_VIDEOSOURCE = WM_CAP_START + ;

private const int WM_CAP_DLG_VIDEODISPLAY = WM_CAP_START + ;

private const int WM_CAP_DLG_VIDEOCOMPRESSION = WM_CAP_START + ;

private IntPtr hWndC;

private bool bStat = false;

private IntPtr mControlPtr;

private int mWidth;

private int mHeight;

private int mLeft;

private int mTop;

/// <summary>

/// 初始化摄像头

/// </summary>

/// <param name="handle">控件的句柄</param>

/// <param name="left">开始显示的左边距</param>

/// <param name="top">开始显示的上边距</param>

/// <param name="width">要显示的宽度</param>

/// <param name="height">要显示的长度</param>

public Pick(IntPtr handle, int left, int top, int width, int height)

{

mControlPtr = handle;

mWidth = width;

mHeight = height;

mLeft = left;

mTop = top;

}

[DllImport("avicap.dll")]

private static extern IntPtr capCreateCaptureWindowA(byte[] lpszWindowName, int dwStyle, int x, int y, int nWidth, int nHeight, IntPtr hWndParent, int nID);

[DllImport("avicap.dll")]

private static extern int capGetVideoFormat(IntPtr hWnd, IntPtr psVideoFormat, int wSize);

[DllImport("User.dll")]

private static extern bool SendMessage(IntPtr hWnd, int wMsg, int wParam, long lParam);

public void capDlgVideoFormat()

{

Boolean capDlgVideoFormat = SendMessage(hWndC, WM_CAP_DLG_VIDEOFORMAT, 0, 0);

}

public void capDlgVideoSource()

{

Boolean capDlgVideoSource = SendMessage(hWndC, WM_CAP_DLG_VIDEOSOURCE, 0, 0);

}

public void capDlgVideoDisplay()

{

Boolean capDlgVideoDisplay = SendMessage(hWndC, WM_CAP_DLG_VIDEODISPLAY, 0, 0);

}

public void capDlgVideoCompression()

{

Boolean capDlgVideoCompression = SendMessage(hWndC, WM_CAP_DLG_VIDEOCOMPRESSION, 0, 0);

}

/// <summary>

/// 开始显示图像

/// </summary>

public void Start()

{

if (bStat)

return;

bStat = true;

byte[] lpszName = new byte[];

hWndC = capCreateCaptureWindowA(lpszName, WS_CHILD | WS_VISIBLE, mLeft, mTop, mWidth, mHeight, mControlPtr, 0);

if (hWndC.ToInt() != 0)

{

SendMessage(hWndC, WM_CAP_SET_CALLBACK_VIDEOSTREAM, 0, 0);

SendMessage(hWndC, WM_CAP_SET_CALLBACK_ERROR, 0, 0);

SendMessage(hWndC, WM_CAP_SET_CALLBACK_STATUSA, 0, 0);

SendMessage(hWndC, WM_CAP_DRIVER_CONNECT, 0, 0);

SendMessage(hWndC, WM_CAP_SET_SCALE, 1, 0);

SendMessage(hWndC, WM_CAP_SET_PREVIEWRATE, , 0);

SendMessage(hWndC, WM_CAP_SET_OVERLAY, 1, 0);

SendMessage(hWndC, WM_CAP_SET_PREVIEW, 1, 0);

}

return;

}

/// <summary>

/// 停止显示

/// </summary>

public void Stop()

{

SendMessage(hWndC, WM_CAP_DRIVER_DISCONNECT, 0, 0);

bStat = false;

}

/// <summary>

/// 抓图

/// </summary>

/// <param name="path">要保存bmp文件的路径</param>

public void GrabImage(string path)

{

IntPtr hBmp = Marshal.StringToHGlobalAnsi(path);

SendMessage(hWndC, WM_CAP_SAVEDIB, 0, hBmp.ToInt());

}

/// <summary>

/// 录像

/// </summary>

/// <param name="path">要保存avi文件的路径</param>

public void Kinescope(string path)

{

IntPtr hBmp = Marshal.StringToHGlobalAnsi(path);

SendMessage(hWndC, WM_CAP_FILE_SET_CAPTURE_FILEA, 0, hBmp.ToInt());

SendMessage(hWndC, WM_CAP_SEQUENCE, 0, 0);

}

/// <summary>

/// 停止录像

/// </summary>

public void StopKinescope()

{

SendMessage(hWndC, WM_CAP_STOP, 0, 0);

}

/* public void cap()

{

CAPTUREPARMS s;

capCaptureGetSetup(m_caphwnd,&s,sizeof(CAPTUREPARMS));//取得采集参数

s.dwRequestMicroSecPerFrame = ;//采集一帧花费1/秒

s.fAbortLeftMouse = FALSE;//压下鼠标左键不终止采集

s.fAbortRightMouse = FALSE;//压下鼠标右键不终止采集

s.fCaptureAudio = TRUE;//c采集音频

s.fYield = TRUE;//使用一个独立的线程来采集视频,不使用View窗口线程

capCaptureSetSetup(m_caphwnd,&s,sizeof(CAPTUREPARMS));//设定采集参数

}*/

}

}

求一个控制摄像头小程序的源码,要求VC下编译运行

VC-摄像头控制SDK源码

#include <windows.h>

#include <stdio.h>

#include <vfw.h>

#pragma comment(lib,"vfw.lib")

HWND ghWndCap ; //捕获窗的句柄

CAPDRIVERCAPS gCapDriverCaps ; //视频驱动器的能力

CAPSTATUS gCapStatus ; //捕获窗的状态

char szCaptureFile[] = "MYCAP.AVI";

char gachBuffer[];

LRESULT CALLBACK WndProc(HWND,UINT,WPARAM,LPARAM);

LRESULT CALLBACK StatusCallbackProc(HWND hWnd,int nID,LPSTR lpStatusText)

{

if(!ghWndCap)return FALSE;//获得捕获窗的状态

capGetStatus(ghWndCap,&gCapStatus,sizeof(CAPSTATUS));//更新捕获窗的大小

SetWindowPos(ghWndCap,NULL,0,0,gCapStatus.uiImageWidth,gCapStatus.uiImageHeight,SWP_NOZORDER|SWP_NOMOVE);

if(nID==0){ //清除旧的状态信息

SetWindowText(ghWndCap,(LPSTR)"hello");

return (LRESULT)TRUE;

}//显示状态ID和状态文本

wsprintf(gachBuffer,"Status# %d: %s",nID,lpStatusText);

SetWindowText(ghWndCap,(LPSTR)gachBuffer);

return (LRESULT)TRUE;

}

LRESULT CALLBACK ErrorCallbackProc(HWND hWnd,int nErrID,LPSTR lpErrorText)

{

if(!ghWndCap)return FALSE;

if(nErrID==0)return TRUE;//清除旧的错误

wsprintf(gachBuffer,"Error# %d",nErrID);//显示错误标识和文本

MessageBox(hWnd, lpErrorText, gachBuffer,MB_OK | MB_ICONEXCLAMATION);

return (LRESULT) TRUE;

}

LRESULT CALLBACK FrameCallbackProc(HWND hWnd,LPVIDEOHDR lpVHdr)

{

FILE *fp;

fp=fopen("caram.dat","w");

if(!ghWndCap)return FALSE;//假设fp为一打开的.dat文件指针

fwrite(lpVHdr->lpData,1,lpVHdr->dwBufferLength,fp);

return (LRESULT)TRUE;

}

int WINAPI WinMain(HINSTANCE hInstance,HINSTANCE hPrevInstance,PSTR szCmdLine,int iCmdShow)

{

static TCHAR szAppName[]=TEXT("HelloWin");

HWND hwnd;

MSG msg;

WNDCLASS wndclass;

wndclass.style=CS_HREDRAW|CS_VREDRAW;

wndclass.lpfnWndProc=WndProc;

wndclass.cbClsExtra=0;

wndclass.cbWndExtra=0;

wndclass.hInstance=hInstance;

wndclass.hIcon=LoadIcon(NULL,IDI_APPLICATION);

wndclass.hCursor=LoadCursor(NULL,IDC_ARROW);

wndclass.hbrBackground=(HBRUSH)GetStockObject(WHITE_BRUSH);

wndclass.lpszMenuName=NULL;

wndclass.lpszClassName=szAppName;

if(!RegisterClass(&wndclass))

{

MessageBox(NULL,TEXT("This program requires WindowsNT!"),szAppName,MB_ICONERROR);

return 0;

}

hwnd=CreateWindow(szAppName,TEXT("The Hello Program"),WS_OVERLAPPEDWINDOW,CW_USEDEFAULT,CW_USEDEFAULT,CW_USEDEFAULT,CW_USEDEFAULT,NULL,NULL,hInstance,NULL);

ShowWindow(hwnd,iCmdShow);

UpdateWindow(hwnd);

while(GetMessage(&msg,NULL,0,0))

{

TranslateMessage(&msg);

DispatchMessage(&msg);

}

return msg.wParam;

}

LRESULT CALLBACK WndProc(HWND hwnd,UINT message,WPARAM wParam,LPARAM lParam)

{

HDC hdc;

PAINTSTRUCT ps;

RECT rect;

switch(message)

{

case WM_CREATE:

{

ghWndCap=capCreateCaptureWindow((LPSTR)"Capture Window",WS_CHILD|WS_VISIBLE,0,0,,,(HWND)hwnd,(int)0);

capSetCallbackOnError(ghWndCap,(FARPROC)ErrorCallbackProc);

capSetCallbackOnStatus(ghWndCap,(FARPROC)StatusCallbackProc);

capSetCallbackOnFrame(ghWndCap,(FARPROC)FrameCallbackProc);

capDriverConnect(ghWndCap,0); // 将捕获窗同驱动器连接

//获得驱动器的能力,相关的信息放在结构变量gCapDriverCaps中

capDriverGetCaps(ghWndCap,&gCapDriverCaps,sizeof(CAPDRIVERCAPS));

capPreviewRate(ghWndCap, ); // 设置Preview模式的显示速率

capPreview(ghWndCap, TRUE); //启动Preview模式

if(gCapDriverCaps.fHasOverlay) //检查驱动器是否有叠加能力

capOverlay(ghWndCap,TRUE); //启动Overlay模式

if(gCapDriverCaps.fHasDlgVideoSource)capDlgVideoSource(ghWndCap); //Video source 对话框

if(gCapDriverCaps.fHasDlgVideoFormat)capDlgVideoFormat(ghWndCap); // Video format 对话框

if(gCapDriverCaps.fHasDlgVideoDisplay)capDlgVideoDisplay(ghWndCap); // Video display 对话框

capFileSetCaptureFile( ghWndCap, szCaptureFile); //指定捕获文件名

capFileAlloc(ghWndCap, (L * L * 5)); //为捕获文件分配存储空间

capCaptureSequence(ghWndCap); //开始捕获视频序列

capGrabFrame(ghWndCap); //捕获单帧图像

}

return 0;

case WM_PAINT:

hdc=BeginPaint(hwnd,&ps);

GetClientRect(hwnd,&rect);

DrawText(hdc,TEXT("Hello,Windows!"),-1,&rect,DT_SINGLELINE|DT_CENTER|DT_VCENTER);

EndPaint(hwnd,&ps);

return 0;

case WM_DESTROY:

{

capSetCallbackOnStatus(ghWndCap,NULL);

capSetCallbackOnError(ghWndCap,NULL);

capSetCallbackOnFrame(ghWndCap,NULL);

capCaptureAbort(ghWndCap);//停止捕获

capDriverDisconnect(ghWndCap); //将捕获窗同驱动器断开

PostQuitMessage(0);

}

return 0;

}

return DefWindowProc(hwnd,message,wParam,lParam);

}

FPGA高端项目:解码索尼IMX MIPI相机转HDMI输出,提供FPGA开发板+2套工程源码+技术支持

FPGA高端项目:解码索尼IMX MIPI相机转HDMI输出,提供FPGA开发板+2套工程源码+技术支持

一、前言

在FPGA图像采集领域,MIPI协议因其复杂性与高技术难度而著称,使得许多开发者望而却步。为了解决这一难题,本设计采用Xilinx Kintex7-T中端FPGA开发板,实现对IMX MIPI摄像头的4 Lane MIPI视频解码,输出分辨率为x@Hz的视频。通过自定义的MIPI CSI RX解码IP实现视频解码,并通过图像ISP进行后期处理,最终输出RGB格式的视频,适用于HDMI输出。提供2套工程源码和FPGA开发板,以及技术支持。

二、相关方案推荐

本博主提供了一系列FPGA工程项目,包括丰富的MIPI编解码方案,涉及Xilinx、Altera、Lattice等不同平台的FPGA实现。为了方便快速定位项目,博主整理了一份工程源码总目录,包含所有项目链接。此外,还专门创建了MIPI编解码专栏,整理了相关博客,方便有需求或兴趣的开发者查阅。

三、MIPI CSI-RX IP 介绍

设计中采用自研的MIPI CSI RX解码IP,实现D_PHY+CSI_RX功能,输出AXI4-Stream格式的RAW颜色视频。该IP适用于Xilinx A7及以上系列器件,支持4 lane RAW图像输入,最高支持4K @帧分辨率。IP UI配置界面提供自定义选项。

四、个人 FPGA 高端图像处理开发板简介

开发板专为高端FPGA图像处理设计,支持公司项目研发、研究、高校项目开发和个人学习。详细介绍了开发板配置和使用方法,推荐用户使用配套工程源码。

五、详细设计方案与设计原理框图

工程源码1采用FDMA缓存架构,设计原理图展示视频处理流程。工程源码2使用VDMA缓存方案,原理图同样展现完整的视频处理流程。

六、IMX及其配置

使用专用的SONY IMX MIPI相机,输出x分辨率,适用于高端项目。相机通过i2c配置,本设计提供自定义的i2c主机IP实现配置。同时,设计了自动曝光程序,确保在不同光照条件下输出清晰图像。

七、工程源码1详解

介绍工程源码1的实现细节,包括使用Xilinx Kintex7 FPGA开发板,Vivado.1环境,以及IMX MIPI相机输入和HDMI输出。采用自研FDMA图像缓存方案,输出分辨率为x@Hz的视频。

八、工程源码2详解

工程源码2同样基于Xilinx Kintex7 FPGA开发板,使用VDMA图像缓存架构,提供与工程源码1相似的功能,输出分辨率为x@Hz的HDMI视频。

九、工程移植说明

针对vivado版本不一致、FPGA型号不一致的情况,提供了解决方案,包括调整工程、配置和升级IP等步骤。

十、上板调试与验证

介绍所需器材,包括FPGA开发板、IMX MIPI相机和HDMI显示器。展示视频输出演示,验证设计的有效性。

十一、工程代码获取

提供某度网盘链接,以方便获取工程代码。代码过大,无法通过邮件发送。

安全生产|西安灞桥:扎实开展锅炉节能环保和安全监管

手机源码论坛_手机源码网

php源码交友

数字搜索源码_数字搜索源码怎么用

安全生产|西安灞桥:扎实开展锅炉节能环保和安全监管

web ssh源码