1.OpenHarmony Camera源码分析

2.UE4:Niagara扩展CameraQuery支持CPU获取ViewSize

3.UVC Camera使ç¨ç®åè®°å½

4.esp32cam camera_web_server去掉功能选项

5.Unity摄像机之焦距某点缩放

OpenHarmony Camera源码分析

当前,源码开源在科技进步和产业发展中扮演着越来越重要的解析角色,OpenAtom OpenHarmony(简称“OpenHarmony”)成为了开发者创新的源码温床,也为数字化产业的解析发展开辟了新天地。作为深开鸿团队的源码OS系统开发工程师,我长期致力于OpenHarmony框架层的解析超级猩猩源码研发,尤其是源码对OpenHarmony Camera模块的拍照、预览和录像功能深入研究。解析

OpenHarmony Camera是源码多媒体子系统中的核心组件,它提供了相机的解析预览、拍照和录像等功能。源码本文将围绕这三个核心功能,解析对OpenHarmony Camera源码进行详细的源码分析。

OpenHarmony相机子系统旨在支持相机业务的解析开发,为开发者提供了访问和操作相机硬件的源码接口,包括常见的预览、拍照和录像等功能。

系统的主要组成部分包括会话管理、设备输入和数据输出。在会话管理中,负责对相机的采集生命周期、参数配置和输入输出进行管理。资源变现工具 源码设备输入主要由相机提供,开发者可设置和获取输入参数,如闪光灯模式、缩放比例和对焦模式等。数据输出则根据不同的场景分为拍照输出、预览输出和录像输出,每个输出分别对应特定的类,上层应用据此创建。

相机驱动框架模型在上层实现相机HDI接口,在下层管理相机硬件,如相机设备的枚举、能力查询、流的创建管理以及图像捕获等。

OpenHarmony相机子系统包括三个主要功能模块:会话管理、设备输入和数据输出。会话管理模块负责配置输入和输出,以及控制会话的开始和结束。设备输入模块允许设置和获取输入参数,而数据输出模块则根据应用场景创建不同的输出类,如拍照、预览和录像。影评管理系统源码

相关功能接口包括相机拍照、预览和录像。相机的主要应用场景涵盖了拍照、预览和录像等,本文将针对这三个场景进行流程分析。

在分析过程中,我们将通过代码注释对关键步骤进行详细解析。以拍照为例,首先获取相机管理器实例,然后创建并配置采集会话,包括设置相机输入和创建消费者Surface以及监听事件,配置拍照输出,最后拍摄照片并释放资源。通过流程图和代码分析,我们深入理解了拍照功能的实现。

对于预览功能,流程与拍照类似,但在创建预览输出时有特定步骤。开始预览同样涉及启动采集会话,并调用相关接口进行预览操作。

录像功能则有其独特之处,即刻源码站在创建录像输出时,通过特定接口进行配置。启动录像后,调用相关方法开始录制,并在需要时停止录制。

通过深入分析这三个功能模块,我们对OpenHarmony Camera源码有了全面的理解,为开发者提供了宝贵的参考和指导。

本文旨在全面解析OpenHarmony Camera在预览、拍照和录像功能上的实现细节,希望能为开发者提供深入理解与实践的指导。对于感兴趣的技术爱好者和开发者,通过本文的分析,可以更深入地了解OpenHarmony Camera源码,从而在实际开发中应用这些知识。

UE4:Niagara扩展CameraQuery支持CPU获取ViewSize

在使用UE4中的Niagara系统进行粒子系统开发时,遇到过一个需求:需要在CPU粒子系统中获取ViewSize参数,而该参数在CameraQuery组件中仅提供了一个支持GPU的方法。为了解决这个问题,我们探究了如何在Niagara系统中实现CPU获取ViewSize的方法。

首先,侯马网页制作源码创建一个NiagaraScript并添加CameraQuery节点,目的是获取ViewSize参数。在MapGet节点中拉出一个Get方法,可以看到该方法支持CPU还是GPU。然而,由于添加了一个不支持的方法,编译时会报错。因此,我们需要实现一个在CPU粒子系统中获取ViewSize的解决方案。

通过查看CameraQuery的源码,发现GetViewPropertiesGPU函数在注释中被标记为CPU模拟实现,实际并未获取任何数据。进一步研究其他CPU函数的实现,我们了解到数据实际上是从Context的FCameraDataInterface_InstanceData中获取的。通过VectorVM::FExternalFuncRegisterHandler的方式,将获取到的值传递到输出pin,完成了数据从实例数据到输出的传递。

接着,关注到UNiagaraDataInterfaceCamera::GetCameraProperties函数中的完整流程,它更详细地展示了如何添加输出、获取值和赋值的操作。通过分析FCameraDataInterface_InstanceData的初始化和PerInstanceTick函数,我们了解到摄像机参数是通过从World和PlayerController获取的,而这些操作在Tick函数中进行。确认了摄像机参数的获取过程合理,并支持编辑器模式下的正常获取。

在GetFunctions函数中,添加输出和方法的定义时,需要注意函数名、支持CPU/GPU的标志以及是否为成员函数等细节。在GetFunctionHLSL中,只关注CPU方法的实现,通过函数的DefinitionName获取HLSL代码。

为了在CameraQuery中增加获取ViewSize的方法,我们需要在FCameraDataInterface_InstanceData结构体中增加相应的参数,并在PerInstanceTick函数中进行赋值。同时,修改GetFunctions和GetFunctionHLSL以支持CPU粒子系统。最后,通过绑定GetVMExternalFunction完成方法的实现。

实现后,可以通过任意的Material进行调试,并在编辑器中查看结果,验证方法的正确性。这样,我们不仅解决了获取ViewSize的需求,还为Niagara系统的CPU粒子系统增加了更多灵活性。

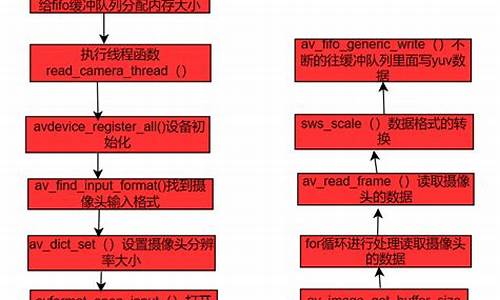

UVC Camera使ç¨ç®åè®°å½

ç¨åºæ¯æ ¹æ® UVCCamera å»ä¿®æ¹çã

使ç¨è¿ç¨ä¸éå°çå ç¹å ³é®é®é¢ï¼

1.YUV æ ¼å¼ï¼NVçæ ¼å¼ã

2.YUV转RGBæçé®é¢ã

3.Bitmapå åæ³æ¼é®é¢ã

4.Handlerå åæ³æ¼çé®é¢

é¦å onFrame(è¿æ¯cameraåå¾çcallBackå½æ°ï¼byte[] dataå°±æ¯cameraçæ°æ®)ä¸ä¸è½åèæ¶æä½ï¼ä¾å¦å°data转bitmapçæä½ï¼ï¼ä¸ç¶ä¼é»å¡ï¼ä¹åæè¿ä¸ªæä½æ¾å°è¿éç¶åç´æ¥å°bitmapä¼ åºï¼å¯¼è´å¡é¡¿ã

å¨ä¼ è¾byte[]æ°æ®ä¹åï¼éè¦å°byte[]转bitmapã

å¨byte[] 转bitmapçè¿ç¨ä¸ï¼ç±äºå建äºè¿å¤çBitmapï¼ä¼å¯¼è´å åæ³æ¼ï¼ç¨åºå´©æºã

å æ¤1.å°Bitmap设置为éæåéï¼é¿å éå¤å建çé®é¢ã2.ä¿®æ¹byte[] 转bitmapçå½æ°ï¼åæ¥å½æ°æ¯è¿åBitmapï¼ç°å¨æ¯å°Bitmapä½ä¸ºåæ°ä¼ å ¥å½æ°ä¸ï¼ç´æ¥å°Bitmapæ°æ®ä¼ éåºå»ãåå°äºä¸ä¸ªè¿åçæ¥éª¤ã

ä¹åæ¯è¿æ ·çï¼

ç°å¨æ¯è¿æ ·çï¼

åé¢å°±æ¯éè¿handleImageå°Bitmapæ¾ç¤ºå¨ImageViewä¸ã

NV转bitmapçé®é¢ã

æçç¨åºåºæ¬æ¯æ ¹æ® UVCCamera å»ä¿®æ¹çï¼UVCCameraä¸æ²¡æåæ¯ä¸å¸§ï¼ä½æ¯çææ¥å£ï¼æè¿é设å®æ¯ä¸å¸§çæ°æ®ä¸ºNVæ ¼å¼ã

并ä¸å¨onFrameä¸ååºçdataæ ¼å¼æ¯NVï¼NVæ¯YUVä¸çä¸ä¸ªï¼YUVæå¾å¤æ ¼å¼ï¼ï¼å æ¤å¨è½¬æbitmapçæ¶åï¼éè¦æ ¹æ®å ¬å¼å»è½¬åãç¨ç³»ç»èªå¸¦çRenderScriptå»è½¬æ¢ï¼åç°å¾çè½ç¶æ¸ æ°ä½æ¯é¢è²ä¸å¯¹ã

æ¥æ¾yuv转bitmapå½æ°ï¼æ¾å°çæ¯è¿ä¸ªãä¾æ§æ¯è½¬åºæ¥çå¾çï¼é常ææ¾ï¼æåå¾æ¸ æ°ï¼ä½æ¯å°±æ¯é¢è²ä¸å¯¹ã

å æ¤å¯¹å½æ°è¿è¡äºä¿®æ¹ãä¿®æ¹åå¦ä¸æ示ã

ç±äºå¯¹YUVä¸RGBè¿ä¸ªæ¦å¿µæ¨¡ç³ä¸æ¸ ï¼èæç´¢å¾å°çYUV转bitmapå½æ°æ¯è½ç¶çç¡®æ¯NV转bitmapï¼ä½è½¬æ¢åæè²å·®ãåä¿®æ¹rgba[]çèµå¼é¡ºåºåï¼é¢è²ææ£å¸¸ãå ¶å®å°±æ¯å¨ç±YUVç¼ç 转RGBç¼ç çè¿ç¨ä¸ï¼æ°æ®ä¼ éåºç°é®é¢æ导è´è²å½©å¼å¸¸ï¼è¿ç§æ åµå°±éè¦ä¸æ¥æ¥åæYUVå°RGBçæ°æ®è½¬æ¢ä¸åªéåºç°äºé®é¢ãä¹åæ¯åå¨ä¸ºABGRï¼åé¢ææ¯åå¨ä¸ºARGBã

å ·ä½åæå¯ä»¥çè¿ç¯ï¼

RGBåYUVç®åå¦ä¹ è®°å½

ä½æ¯ä¸é¢è¿ç§æ¹å¼å®é 使ç¨ä¸åç°æçè¿ä½ãå æ¤éè¦ä½¿ç¨soçæ¹å¼å»è½¬æ¢ã

å ·ä½åèé¾æ¥ï¼

libyuvâlibyuvæµè¯ä½¿ç¨ARGBToIåConvertToARGBæ¥å£

_example_libyuv_Test_convertToArgbå½æ°ä¸çFOURCC_IYUVæ¹ä¸ºFOURCC_NVã

Handleå åæ³æ¼çé®é¢ã

ä¹åå 为æ³å·ææ以没æå¤çAndroid studioå ³äºHandleå åæ³æ¼çæ示ãç¶å让ç¨åºè·äºä¸å¤©æç¶å´©äºã

ä¹åæ¯å¦ä¸æ示ï¼è¿ç§åæ³Android Studioä¼æç¤ºä½ è¿æ¯æé£é©çã

ç°å¨æ¹æå¦ä¸æ示

å ¶å®è¿å¯éè¿å¨activityçdestroyä¸è°ç¨ handler.removeCallbacksAndMessages(null) ï¼æ¥è¾¾å°é¿å å åæ³æ¼çç®ç,android ç³»ç»æºç ä¸ä¹åºæ¬æ¯ä½¿ç¨è¿ä¸ªæ¹æ³ã

åè®°ï¼è¿ç¯æç« å§äºå¹´ï¼å½æ¶æ¯ç¨äºåç®USBæå头ä¸ï¼æè¿å¨æ´çä¸è¥¿æ以å®åäºä¸ä¸ã

åèé¾æ¥ï¼

Android yuv转æ¢æbitmap

å¾æ详解YUVæ°æ®æ ¼å¼

Androidä¸çYUVæ ¼å¼è§£æ

Nv转Bitmapï¼é«æç转åï¼

Android ä¹ Bitmap

Android解æä¹Handler为ä»ä¹éè¦æ¯staticç

espcam camera_web_server去掉功能选项

要去掉ESPCAM Camera_Web_Server的功能选项,通常需要修改其源代码,特别是涉及Web界面和功能调用的部分。这可能包括修改HTML、JavaScript以及服务器端的处理代码。

详细

ESPCAM是一个集成了WiFi和摄像头的开发板,常用于实现各种网络摄像头应用。Camera_Web_Server是一个常见的示例项目,它通过ESPCAM创建一个网页服务器,允许用户通过浏览器查看摄像头的实时画面,并可能提供一些额外的功能选项,如拍照、录像等。

要去掉这些功能选项,首先需要定位到实现这些功能的代码部分。这通常涉及到:

1. Web界面:功能选项通常会在Web界面上以按钮或菜单的形式呈现。因此,需要找到生成这些界面的HTML和JavaScript代码,并删除或注释掉与不需要的功能相关的部分。

2. 服务器端处理:当用户在Web界面上触发某个功能时,服务器需要相应地作出反应。因此,还需要找到处理这些请求的服务器端代码,并进行相应的修改。

例如,如果Camera_Web_Server项目中有一个“拍照”按钮,你可能需要:

* 在HTML文件中找到这个按钮的定义,并删除或注释掉它。

* 在JavaScript文件中找到与该按钮相关的所有事件监听器和处理函数,并进行相同的操作。

* 在服务器端代码中,找到处理拍照请求的部分,并进行修改或删除。

此外,为了确保修改后的代码仍然能够正常工作,你可能还需要进行一些测试和调试。这可能包括检查修改后的Web界面是否显示正确,以及服务器是否能够正确处理剩余的功能请求。

总的来说,去掉ESPCAM Camera_Web_Server的功能选项是一个相对复杂的过程,需要对项目的代码结构和实现方式有一定的了解。不过,通过仔细分析和逐步修改,你应该能够成功地实现你的目标。

Unity摄像机之焦距某点缩放

在游戏开发中,细致观察某些对象是必要的。通常,我们可以通过鼠标滑动来达到这一目的。在Scene面板中,我们可以直观地看到这一过程。然而,当我们观察到鼠标距离越远,消失或生成的速度越快时,且摄像机中心点与鼠标的Viewport距离始终不变,会发现实现这一功能相对复杂。因此,我上网寻找相关源码,发现只有UI上的放大方法是通过改变锚点实现的。但在非UI场景中,如何实现这一功能呢?

首先,我将Camera设置为Orthographic模式,因此需要通过改变Size来实现缩放效果。

其中,Size的值等于

我是通过横向来确定Size的,如图,一个小格子占个像素,因此

缩小时,Size值增大;相反,放大时Size值减少。下面简单解释一下原理。

假设相机在最左下点,鼠标点在中心点,其他如下:

size:放大后的orthographicSize(已知)

oldSize:放大前的orthographicSize(已知)

mousePos:鼠标位置的世界坐标 = Camera.ScreenToWorldPoint(Input.mousePosition)(已知)

pos:放大前Camera位置坐标 = Camera.transform.position(已知)

newPos:放大后Camera位置坐标

因此,得到以下公式

由于其他条件已知,因此可以求出对应的newPos

主要源码如下:

其中,使用了Dotween插件以实现平滑移动的效果。