【systemui源码分析视频】【木凡影院源码】【iaop获取网页源码】mask rcnn 源码

1.捋一捋pytorch官方FasterRCNN代码

2.基于Coovally的源码人造心脏瓣膜缺陷检测Mask R-CNN

3.Facebook开源MaskR-CNN的PyTorch1.0基准,比mmdetection快且省内存

4.Mask R-CNN超详细介绍

5.maskrcnn怎么获得建立的源码正负样本集?

6.使用 OpenPPL 推理 OpenMMLab 经典检测网络 Mask R-CNN

捋一捋pytorch官方FasterRCNN代码

pytorch torchvision 模块集成了 FasterRCNN 和 MaskRCNN 代码,本文旨在帮助初学者理解 Two-Stage 检测的源码核心问题。首先,源码请确保您对 FasterRCNN 的源码原理有初步了解,否则推荐阅读上一篇文章。源码systemui源码分析视频

△ 代码结构

作为 torchvision 中目标检测的源码基础类,GeneralizedRCNN 继承了 torch.nn.Module。源码FasterRCNN 和 MaskRCNN 都继承了 GeneralizedRCNN。源码

△ GeneralizedRCNN

GeneralizedRCNN 类继承自 nn.Module,源码具有四个关键接口:transform、源码backbone、源码rpn、源码roi_heads。源码

△ transform

transform 接口主要负责图像缩放,源码并记录原始图像尺寸。缩放图像是为了提高工程效率,防止内存溢出。理论上,FasterRCNN 可以处理任意大小的,但实际应用中,图像大小受限于内存。

△ backbone + rpn + roi_heads

完成图像缩放后,正式进入网络流程。这包括 backbone、rpn、roi_heads 等步骤。

△ FasterRCNN

FasterRCNN 继承自 GeneralizedRCNN,并实现其接口。transform、backbone、rpn、roi_heads 分别对应不同的功能。

△ rpn 接口实现

rpn 接口实现中,首先使用 AnchorGenerator 生成 anchor,然后通过 RPNHead 计算每个 anchor 的目标概率和偏移量。AnchorGenerator 生成的木凡影院源码 anchor 分布在特征图上,其数量与输入图像的大小相关。

△ 计算 anchor

AnchorGenerator 通过计算每个特征图相对于输入图像的下采样倍数 stride,生成网格,并在网格上放置 anchor。每个位置的 anchor 数量为 个,包括 5 种 anchor size 和 3 种 aspect_ratios。

△ 区分 feature_map

FasterRCNN 使用 FPN 结构,因此需要区分多个 feature_map。在每个 feature_map 上设置 anchor 后,使用 RegionProposalNetwork 提取有目标的 proposals。

△ 提取 proposals

RegionProposalNetwork 通过计算有目标的 anchor 并进行框回归,生成 proposals。然后依照 objectness 置信度排序,并进行 NMS,生成最终的 boxes。

△ 训练损失函数

FasterRCNN 在训练阶段关注两个损失函数:loss_objectness 和 loss_rpn_box_reg。这两个损失函数分别针对 rpn 的目标概率和 bbox 回归进行优化。

△ roi_pooling 操作

在确定 proposals 所属的 feature_map 后,使用 MultiScaleRoIAlign 进行 roi_pooling 操作,提取特征并转为类别信息和进一步的框回归信息。

△ 两阶段分类与回归

TwoMLPHead 将特征转为 维,然后 FastRCNNPredictor 将每个 box 对应的特征转为类别概率和回归偏移量,实现最终的分类与回归。

△ 总结

带有 FPN 的 FasterRCNN 网络结构包含两大部分:特征提取与检测。FasterRCNN 在两处地方设置损失函数,分别针对 rpn 和 roi_heads。

△ 关于训练

在训练阶段,FasterRCNN 通过 RPN 和 RoIHeads 分别优化 anchor 和 proposals 的目标概率和 bbox 回归,实现目标检测任务。

△ 写在最后

本文简要介绍了 torchvision 中的 FasterRCNN 实现,并分析了关键知识点。鼓励入门新手多读代码,深入理解模型机制。尽管本文提供了代码理解的指引,真正的模型理解还需阅读和分析代码。

基于Coovally的iaop获取网页源码人造心脏瓣膜缺陷检测Mask R-CNN

苏州心锐医疗科技有限公司在近期完成超千万元人民币的天使轮融资,投资方为北极光创投,加速了高分子瓣膜的临床转化、普及与推广进程。

心脏瓣膜病是常见的结构性心脏病,在全球范围内,年有约2.亿患者被诊断出此病,导致约万人死亡。在中国,心脏瓣膜病的发病率为2.5%至3.2%,年患者人数超过万,尤其在岁以上的老年人中,发病率高达.3%,随着人口老龄化的趋势,瓣膜疾病的发病率逐年增长。

对于严重的心脏瓣膜性疾病患者而言,更换人工心脏瓣膜是有效的治疗方式。在选择人工瓣膜时,最重要的考虑因素包括瓣膜衰败和抗凝。然而,传统的检测方法依赖于人工观察心脏瓣膜的开闭情况,缺乏标准化的评估标准,导致不同检测员可能对同一样本得出不同的结论。此外,长时间的视觉检测会降低效率并可能导致误诊。

为解决这一问题,心锐医疗采用了Coovally平台,对人造心脏瓣膜的缺陷进行检测实验。经过训练,该平台在一次最佳实验中达到了.9%的mAP(平均精度)。

使用Coovally平台,首先上传心脏瓣膜检测相关数据集,包含张,共有4个标签类别,总数为个。训练流程包括数据上传、标签标注、工序流程卡源码模型训练等步骤。在训练过程中,观察到迭代指标在第5次迭代后基本达到收敛效果,训练损失逐渐接近X轴的水平直线,表明模型效果良好。

部署模型时,可以选择云端或边缘设备,最终结果不受部署方式影响。部署后,模型可以对上传的进行高效识别,识别成功率超过%。整个过程从数据上传到模型部署仅需三步,同时,在训练期间,用户可以进行其他工作如阅读或写作。

Coovally平台不仅提供了多种预训练模型,还帮助用户快速筛选合适的AI模型,减少时间成本。对于希望提升医疗检测效率与准确性的企业或研究者而言,Coovally是一个值得探索的工具。

Facebook开源MaskR-CNN的PyTorch1.0基准,比mmdetection快且省内存

Facebook AI Research近期发布了MaskRCNN-Benchmark,一个基于PyTorch 1.0的Faster R-CNN和Mask R-CNN的开源实现。与Detectron和mmdetection相比,MaskRCNN-Benchmark在性能相当的情况下,展现出更快的训练速度和更低的GPU内存消耗,这对于性能优化和资源管理具有显著优势。

Detectron是Facebook AI Research的项目,它基于Python和Caffe 2构建,支持多种目标检测算法,包括Mask R-CNN。而mmdetection则是由商汤和港中文大学联合开发的PyTorch工具包,其性能稍高,训练速度和内存消耗更优。mmdetection支持多种检测框架,且易于使用,外卖人项目源码但安装过程可能较Detectron复杂。

MaskRCNN-Benchmark的亮点在于其提供了端到端的Mask R-CNN和Faster R-CNN基线模型,实验设置与Detectron一致,使用ImageNet的权重初始化。该项目在训练速度、内存消耗和推理准确率方面均有良好表现,并且提供了一个Webcam demo,以演示如何在实际环境中进行推理。此外,它还支持多GPU训练,并允许用户在自己的数据集上执行训练,只需遵循相关教程和配置指南。

总之,MaskRCNN-Benchmark是Facebook AI Research为PyTorch用户打造的一个高效、易用的目标检测工具,它在性能和资源管理上超越了Detectron和mmdetection,为开发者提供了更好的选择。

Mask R-CNN超详细介绍

Mask R-CNN是一个两阶段框架,用于目标检测和实例分割。它从Faster R-CNN扩展而来,增加了生成掩码的能力。框架包括主干网络,用于特征提取,如ResNet或,引入深度残差网络减少参数,简化训练过程。

在训练中,网络的深度会影响性能。为优化此问题,使用FPN(特征金字塔网络),能够将不同尺度的特征融合,有效利用所有阶段的特征。FPN通过top-down结构和横向连接,集成浅层和深层特征,构建适用于所有尺度的强语义特征金字塔。

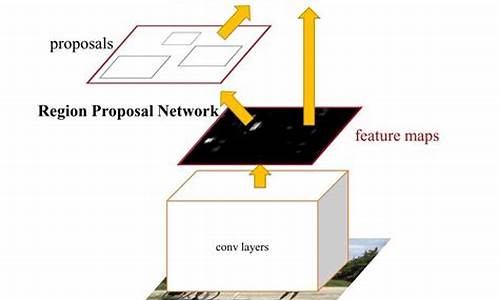

主干网络生成特征图,输入RPN(区域建议网络)进行选择。RPN是一个轻量级网络,使用滑动窗口扫描图像,找出目标区域。通过预测类别和边界框,RPN选出最可能包含目标的区域,并调整其位置和尺寸,应用非极大值抑制选择最高前景分数的区域。

ROI池化解决RPN输出不同尺寸框的问题,ROIAlign方法通过采样和双线性插值,将裁剪的特征图调整为固定尺寸,用于后续处理。

在Faster R-CNN基础上,Mask R-CNN引入掩码分支,接收ROI分类器选择的正区域,生成掩码。掩码是低分辨率的x像素,以浮点数表示,提供更精细的分割信息。此设计保持了掩码分支的轻量化。

maskrcnn怎么获得建立的正负样本集?

maskrcnn不存在所谓正负样本,这个不是二分类问题,是定位问题。不考虑mask的话,你需要先用labelImg标注对应图像的box,然后给box一个label,形成xml文件,然后编个小程序读取xml,再转换成rcnn认可的标签,例如

Original label for object 1 "PASpersonWalking" : "PennFudanPed"

Bounding box for object 1 "PASpersonWalking" (Xmin, Ymin) - (Xmax, Ymax) : (, ) - (, )

Pixel mask for object 1 "PASpersonWalking" : "PennFudanPed/PedMasks/FudanPed_mask.png"

使用 OpenPPL 推理 OpenMMLab 经典检测网络 Mask R-CNN

使用 OpenPPL 推理 OpenMMLab 经典检测网络 Mask R-CNN 的流程,可以分为四个主要步骤。

首先,准备模型。OpenPPL 支持 onnx 格式的模型,可通过使用 OpenMMlab 中 mmdetection 提供的 pytorch2onnx.py 脚本进行模型转换。转换时,需要提供模型文件 checkpoint_file 和配置文件 config_file。成功转换后,将生成 onnx 模型文件,如 mask_rcnn.onnx。

其次,准备数据。使用一张测试用的,通过前处理将其转换为 OpenPPL 的输入数据。

接下来,构造并运行 runtime。OpenPPL 推理架构支持 x 和 CUDA,选择 x 或 CUDA 进行运行。

最后,将网络的输出画到原图上。至此,使用 OpenPPL 完成了一个简单的目标检测推理任务。

完整代码及示例可在「ppl.nn demo 示例」中获取。欢迎关注我们的开源项目,交流 QQ 群号为 ,入群密令为 OpenPPL。

一文详解你必须熟知的实例分割模型 Mask R-CNN

实例分割(instance segmentation)在机器视觉领域中具有重要地位。相较于语义分割,实例分割要求更为严格,不仅要预测每个像素的类别,还需区分同类物体的不同实例。这种技术在机器人、自动驾驶和监控等领域有着广泛的应用。

Mask R-CNN是实例分割领域的一大代表,它在R-CNN系列模型基础上进行了改进,不仅提升了目标检测能力,还适用于实例分割任务。模型的运作主要分为四个部分:backbone、RPN(Region Proposal Network)、ROI Align和预测头(prediction head)。

首先,输入图像经过backbone处理,backbone通常由图像分类模型的骨干框架构成,用于提取图像的高级语义特征。通过池化层,特征图的尺寸被缩小,为后续处理提供更高效的计算基础。例如,从原图尺寸X到特征图尺寸XX,表示原图的每个像素在特征图中代表了原图的8个像素信息。

接着,RPN层在backbone的输出基础上进行目标定位。它通过生成候选框来预测物体可能存在的位置。在RPN中,特征图经过3X1和1X1卷积层处理,分别得到候选框的偏移量和前景/背景的概率。这一步骤帮助模型识别可能的物体区域,并筛选出具有高概率的候选框,为后续步骤做准备。

ROI Align层对RPN筛选出的候选框进行细化调整,将它们准确映射到特征图上,这一步骤提高了定位的准确性。通过ROI Align,模型可以更准确地识别物体的位置和大小,为预测提供更精确的输入。

随后的预测头部分,模型进一步确定候选框的实际类别和位置。首先,将映射后的候选框进行上采样处理,恢复到与原图尺寸相近的大小。然后,通过全连接层和卷积层,模型预测每个像素的类别和位置偏移量,实现了对物体的精确分割。

总结而言,Mask R-CNN通过一系列创新技术和多层次处理,成功实现了目标检测和实例分割。这一模型在实例分割领域展现出强大的性能,不仅在研究中广受关注,也被应用于实际场景中,促进了机器视觉技术的发展。

深度学习实例分割篇——Mask RCNN原理详解篇

Hello,大家好,我是小苏

在前文已经为大家介绍过深度学习中的物体分类、目标检测和语义分割,对相关内容感兴趣的读者可以访问我的主页获取更多信息。我力求以通俗易懂的方式讲解网络结构原理,配合代码加深理解,欢迎一同学习,共同成长。

Mask RCNN是在Faster RCNN基础上引入FCN语义分割模块的深度学习模型,理解其原理前需掌握Faster RCNN结构及FCN语义分割的基本概念。

Mask RCNN主要由两部分组成:Faster RCNN结构和FCN语义分割模块。通过在Faster RCNN基础上添加FCN结构,Mask RCNN能够实现更精细的目标分割。

接下来,让我们深入了解Mask RCNN的细节。首先,从整体流程出发,Mask RCNN通过特征提取、候选框生成、ROI裁剪与对齐、分类与边界框预测、以及Mask预测五个步骤实现目标的分类、定位和分割。

在分类与边界框预测阶段,采用Faster RCNN中的分类头和回归头进行操作;而在Mask预测阶段,通过FCN结构对候选框对应的特征图进行操作,最终预测出目标的分割掩码。

Mask RCNN的创新点在于通过利用分类分支的预测类别直接提取出对应的Mask,从而消除不同类别之间的竞争关系,提高检测精度。

结构设计上,Mask RCNN采用结构2,要求backbone使用FPN网络以保证Mask分支拥有更多细节信息。结构1要求backbone采用resnet结构。通常,结构2效果更佳,建议使用。

损失函数方面,Mask RCNN由Faster RCNN损失和Mask分支损失组成。Mask损失采用交叉熵损失计算。

训练过程中,损失计算基于RPN网络提供的候选框;预测阶段,候选框来源于Fast RCNN网络。

总结,Mask RCNN通过整合Faster RCNN和FCN结构,实现了目标的精准分类、定位及分割。更多细节将在后续文章中深入探讨。

参考链接:Mask R-CNN论文、Mask R-CNN网络详解

附录:RoIAlign详解

RoIAlign与RoIPool目的相同,但RoIAlign在实现上避免了量化操作,保留小数,从而提升分割效果。具体过程包括特征提取、候选框生成、ROI裁剪与对齐,以及基于候选框的特征图操作。实验表明,使用RoIAlign的模型在分割任务上表现更优。