1.Hudi 基础入门篇

2.hadoop å®è£

å

çåºå«ãå¨çº¿ç谢谢åä½ã

3.Hadoop3.3.5集成Hive4+Tez-0.10.2+iceberg踩坑过程

4.求助,关于hbase的versions问题

Hudi 基础入门篇

为了深入理解Hudi这一湖仓一体的流式数据湖平台,本文将提供一个基础入门的步骤指南,从环境准备到编译与测试,再到实际操作。

在开始之前,自动填写vb源码首先需要准备一个大数据环境。第一步是安装Maven,这是构建和管理Hudi项目的关键工具。在CentOS 7.7版本的位操作系统上,通过下载并解压Maven软件包,然后配置系统环境变量,即可完成Maven的安装。确保使用的Maven版本为3.5.4,仓库目录命名为m2。android无障碍源码

接下来,需要下载Hudi的源码包。通过访问Apache软件归档目录并使用wget命令下载Hudi 0.8版本的源码包。下载完成后,按照源码包的说明进行编译。

在编译过程中,将需要添加Maven镜像以确保所有依赖能够正确获取。完成编译后,进入$HUDI_HOME/hudi-cli目录并执行hudi-cli脚本。如果此脚本能够正常运行,说明编译成功。

为了构建一个完整的数据湖环境,需要安装HDFS。从解压软件包开始,免费微门户源码配置环境变量,设置bin和sbin目录下的脚本与etc/hadoop下的配置文件。确保正确配置HADOOP_*环境变量,以确保Hadoop的各个组件可以正常运行。

下一步,需要配置hadoop-env.sh文件,以及核心配置文件core-site.xml和HDFS配置文件hdfs-site.xml。这些配置文件中包含了Hadoop Common模块的公共属性、HDFS分布式文件系统相关的属性,以及集群的节点列表。通过执行格式化HDFS和启动HDFS集群的命令,可以确保HDFS服务正常运行。

总结而言,Hudi被广泛应用于国内的dns分发源码大公司中,用于构建数据湖并整合大数据仓库,形成湖仓一体化的平台。这使得数据处理更加高效和灵活。

为了更好地学习Hudi,推荐基于0.9.0版本的资料,从数据湖的概念出发,深入理解如何集成Spark和Flink,并通过实际需求案例来掌握Hudi的使用。这些资料将引导用户从基础到深入,逐步掌握Hudi的核心功能和应用场景。

hadoop å®è£ å çåºå«ãå¨çº¿ç谢谢åä½ã

hadoop-2.6.0-src.tar.gzæ¯æºç å缩æ件ãå¯ä»¥ç¨eclipseå¯¼å ¥ç 究æºç ï¼æè Mavenæ建ç¼è¯æå ã

hadoop-2.6.0.tar.gzæ¯å·²ç»å®æ¹åå¸çå缩å ï¼å¯ä»¥ç´æ¥ä½¿ç¨ãä¸è¿å®ç½ä¸è½½çhadoopåå¸çæ¬åªéåxç¯å¢ï¼è¥è¦xçåéè¦Mavenéæ°æ建ã

*.mds æ¯æè¿°æ件ï¼è®°å½å缩å çMD5ï¼SHA1çä¿¡æ¯ã

Hadoop3.3.5集成Hive4+Tez-0..2+iceberg踩坑过程

在集成Hadoop 3.3.5、Hive 4、Tez 0..2以及Iceberg 1.3的过程中,我们面对了诸多挑战,element-ui源码并在多方寻找资料与测试后成功完成集成。以下为集成步骤的详细说明。

首先,确保Hadoop版本为3.3.5,这是Hive运行的前置需求。紧接着,安装Tez作为计算引擎。由于Tez 0..2的依赖版本为3.3.1,与当前的Hadoop版本不符,因此,我们需手动编译Tez以避免执行SELECT操作时出现的错误。编译前,下载官方发布的Tez源码(release-0..2),并解压以获取编译所需文件。编译过程中,注意更新pom.xml文件中的Hadoop版本号至3.3.5,同时配置protoc.path为解压后的protoc.exe路径,并添加Maven仓库源。确保只编译tez-0..2-minimal.tar.gz,避免不必要的编译耗时。完成后,将编译好的文件上传至HDFS,并在主节点hadoop配置目录下新增tez-site.xml,同步配置至所有节点后重启集群。

Hive作为基于Hadoop的数据仓库工具,提供SQL查询和数据分析能力,新版本Hive 4集成了Iceberg 1.3,无需额外配置。本次集成步骤包括下载、解压、配置环境变量及初始化元数据。下载最新的Hive 4.0.0-beta-1版本,解压并配置环境变量,删除指定jar文件以避免提示错误。修改配置文件以设置Hive环境变量,并确保连接信息正确。初始化Hive元数据后,可以使用hive执行文件启动Hive服务。编写hive_management.sh脚本以实现Hive服务的管理。

通过beeline命令进行连接,执行创建数据库和表的SQL语句,使用Hive进行数据插入和查询。值得注意的是,Hive 4.0.0-beta-1已集成Iceberg 1.3,因此无需额外加载jar包,只需将计算引擎设置为Tez。若需更新Iceberg版本,需下载Hive源码,修改依赖并编译特定包。

为了创建Iceberg分区表,使用熟悉的Hive命令语法,例如创建分区表时使用STORED BY ICEBERG。分区规范的语法也与Spark相似,可在HMS中获取Iceberg分区详细信息,并执行相应的数据转换操作。参考文档提供了从安装至配置的详细指导,确保了集成过程的顺利进行。

求助,关于hbase的versions问题

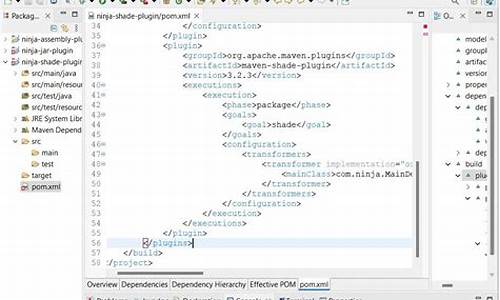

在apache上下载的hbase,默认的编译版本是根据hadoop-1.0.3的。需要用其他版本的hadoop的,要对hbase进行重新编译。编译并不难,但是第一次,还是出了很多很多状况。PS:HBase版本:hbase-0..1hadoop版本2.0.,下载maven。(hbase是用maven编译的,hadoop用ant)2,hbase的pom.xml里面hadoop2.0用的是2.0.0-alpha,编辑pom.xml,把2.0.0-alpha改成:2.0.0-alpha。3,到hbase-0..1的安装目录下,执行如下语句:Shell代码${ MAVEN_HOME}/bin/mvn-e-Dmaven.test.skip.exec=true-Dhadoop.profile=2.0package然后就是等待了,大概讲下各个参数的含义:-e编译时打印出详细错误信息-Dmaven.test.skip.exec=true编译时跳过测试步骤-Dhadoop.profile=2.0编译时使用hadoop.profile2.0,也就是针对2.0的hadoop编译。4,然后就是到target路径下找hbase-0..1.tar.gz的包,用这个包部署。