1.从零开始写一个RTSP服务器(五)RTP传输AAC

2.详解 WebRTC 协议原理与框架、WebRTC编程问题迎刃而解

3.WebRTC PeerConnection源码分析1-main window/附:WebRTC源码级深度解析,进阶大厂高级音视频开发者课程

4.unimrcpclient源码分析mrcp components

5.ZLMediaKit 服务器源码解读---RTSP推流拉流

6.详解 WebRTC 协议原理与框架

从零开始写一个RTSP服务器(五)RTP传输AAC

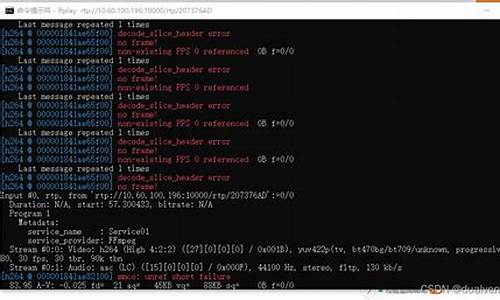

本文目标:实现通过VLC播放SDP文件并听到AAC音频。1. RTP封装与发送

虽然前面已介绍过,但为了回顾,这里再次提及。简单代挂源码RTP数据包由头部和载荷组成,我们构建了一个结构体来代表RTP头部,并创建了发送包的函数。RTP头部的细节请参考之前关于RTSP协议的文章。 下面是RTP包和发送函数的实现,其中使用htons函数来确保网络字节序(大端模式)的正确性:rtp.h 和 rtp.c 文件在此部分频繁使用。

2. AAC RTP打包

AAC音频以ADTS帧的形式存在,每个ADTS帧有特定的7字节头部,包含了帧大小信息。将AAC帧的头部和数据分开,仅保留AAC数据部分,每帧打包成一个RTP包。RTP载荷前四个字节有特殊含义,后面是AAC数据,大小在第三个和第四个字节中用位表示。3. AAC SDP媒体描述

媒体描述的SDP格式包括"M="行,指定音频类型、端口、传输协议和负载类型。例如,`m=audio RTP/AVP `,表示音频流使用号负载类型(AAC)。详细SDP内容可参考RTSP协议讲解。4. 测试与操作

将源代码(rtp.c、rtp.h 和 rtp_aac.c)与sdp文件(rtp_aac.sdp) 保存,使用test.aac作为音频源。编译并运行程序,确保运行时的IP地址与SDP中指定的目标地址一致,然后通过VLC加载SDP文件,即可听到音频。zeromq 源码学习后续文章将介绍如何构建完整的AAC RTSP发送服务器。详解 WebRTC 协议原理与框架、WebRTC编程问题迎刃而解

WebRTC,全称Web Real-Time Communication,是一种允许网页浏览器进行实时语音和视频对话的API,自年由Google等公司开源并被W3C推荐后,迅速在开发者中普及。它通过SRTP加密RTP数据,确保通信的安全性。核心架构由四部分组成:Voice Engine、Video Engine、Transport以及应用层API,各自处理音频、视频、传输和扩展功能。

在架构图中,绿色部分代表WebRTC核心层,提供基础API,紫色部分是应用层,开发者可以根据需要扩展。核心层的Voice Engine包含编码解码、网络适配和回音消除等功能,Video Engine负责VP8/VP9视频编解码,以及防止视频抖动和图像处理。Transport模块则利用UDP协议实现高效、实时的数据传输,并通过计算估计网络带宽,支持非音视频数据传输。

要使用WebRTC,开发者可以利用javascript Web API或本地C++ API,开发实时通信应用。WebRTC允许基于浏览器的网络流API、RTCPeerConnection和P2P数据API构建应用,如音频视频聊天。架构上,expat 源码解析WebRTC通过P2P直接在浏览器间传输媒体流,但需要通过ICE、STUN和TURN等协议解决NAT和防火墙带来的挑战。

WebRTC协议栈涉及RTP、SETP、SCTP等协议,Session组件基于libjingle库,而Transport层则使用了libjingle的网络和传输组件。源码结构复杂且快速变化,涉及PeerConnection、模块化设计、网络传输模块和基础网络协议理解,如RTP报头格式、RTCP报告和扩展等。

学习WebRTC需要对基本网络协议有深入理解,如RTP负载格式、RTP报头扩展以及RTCP报告间隔。资源方面,可通过书籍、示例代码和开发者社区来深入学习,如跨平台的WebRTC Demo项目。

WebRTC PeerConnection源码分析1-main window/附:WebRTC源码级深度解析,进阶大厂高级音视频开发者课程

当前音视频行业蓬勃发展,WebRTC作为优秀的音视频开源库,广泛应用于各种音视频业务中。对于高级音视频开发者而言,掌握业务适用性改造能力至关重要。深入学习与分析WebRTC,从中汲取有益经验,对开发者而言具有极高的价值。

本文基于WebRTC release-源码及云信音视频团队的经验,主要探讨以下问题:ADM(Audio Device Manager)架构解析、启动流程分析、数据流向解析。本文聚焦核心流程,socket内核源码旨在帮助开发者在有需求时快速定位相关模块。

ADM架构解析

在WebRTC中,ADM(Audio Device Manager)的行为由AudioDeviceModule定义,实现则由AudioDeviceModuleImpl提供。通过架构图可以看出,AudioDeviceModule全面规定了ADM的所有行为。AudioDeviceModule的主要职责在于管理音频设备的采集与播放。

AudioDeviceModule由AudioDeviceModuleImpl实现,包含音频设备实例audio_device_和音频缓冲区audio_device_buffer_。audio_device_负责与具体平台的音频设备交互,audio_device_buffer_用于存储音频缓冲区数据,是与AudioDeviceModuleImpl中的audio_device_buffer_同一对象。AudioDeviceModuleImpl通过AttachAudioBuffer()方法将audio_device_buffer_传递给平台实现。

音频缓冲区AudioDeviceBuffer包含play_buffer_与rec_buffer_,分别用于播放与采集音频数据。AudioTransport接口定义了向下获取播放与传递采集数据的核心方法。

关于ADM扩展的思考

在WebRTC实现中,主要关注硬件设备的实现,对于虚拟设备的支持不足。但在实际项目中,往往需要外部音频输入/输出支持。这可以通过在AudioDeviceModuleImpl中引入虚拟设备,实现与真实设备的切换或协同工作,简化了设备管理。

ADM设备启动时机与流程

ADM设备启动时机并不严格,通常在创建后即可启动。WebRTC源码中会在SDP协商后检查是否需要启动相关设备,根据需求启动采集或播放设备。启动流程涉及InitXXX与StartXXX方法,最终调用平台实现。

关于设备停止

了解启动过程后,设备停止逻辑与启动逻辑大体相似,主要涉及相关方法的调用。

ADM音频数据流向

音频数据发送核心流程涉及硬件采集、APM处理、libevent 源码下载RTP封装、网络发送等步骤。数据接收与播放则包括网络接收、解包、解码、混音与播放,整个流程清晰且高效。

unimrcpclient源码分析mrcp components

配置样例包含六个部分。

函数unimrcp_client_components_load主要负责这六个组件的加载,下面详细解析各个组件的加载过程。

加载resource组件时,其结构体mrcp_resource_t定义在mrcp_resource.h,字符串使用apt_str_table_item_t(定义在mrcp_resource_loader.c),mrcp_resource_loader_t和mrcp_resource_factory_t分别位于mrcp_resource_loader.c和mrcp_resource_factory.c。构造mrcp_resource_loader内部是mrcp_resource_factory_t *factory,factory通过mrcp_resource_factory_create构建,参数为MRCP_RESOURCE_TYPE_COUNT的第5个值,整型值为4。

加载sip-uac组件时,mrcp_sofia_client_config_t结构体(mrcp_sofiasip_client_agent.c)应用于sofia sip协议栈。默认端口和名称设定如下:config->local_port = DEFAULT_SIP_PORT; 默认端口为,config->user_agent_name = DEFAULT_SOFIASIP_UA_NAME; 默认agent name为UniMRCP SofiaSIP,config->origin = DEFAULT_SDP_ORIGIN; 默认sdp origin为UniMRCPClient。IP地址配置通过unimrcp_client_ip_address_get(unimrcp_client.c)实现,可配置为“auto”或“iface”。然后使用mrcp_sofiasip_client_agent_create(mrcp_sofiasip_client_agent.c)创建sofiasip_client。

加载rtsp-uac组件时,指代MRCPv1版本的uac组件。rtsp_client_config_t结构体(mrcp_unirtsp_client_agent.h)用于配置。组件加载通过unimrcp_client_rtsp_uac_load函数完成。

加载media-engine组件时,配置项仅包含realtime_rate。unimrcp_client_media_engine_load函数负责加载此组件。mpf_engine_t结构体(mpf_engine.c)用于创建mpf_engine,使用mpf_engine_create函数。

加载rtp-factory组件时,mpf_rtp_config_t结构体(mpf_rtp_descriptor.h)包含可配置项。unimrcp_client_rtp_factory_load函数用于加载此组件,并通过mpf_rtp_termination_factory_create(mpf_rtp_termination_factory.c)创建相应的工厂。

ZLMediaKit 服务器源码解读---RTSP推流拉流

RTSP推流与拉流在ZLMediaKit服务器源码中有着清晰的解析过程和处理逻辑。数据解析通过回调到达RtspSession类的onRecv函数,进而进行分包处理,头部数据与内容分离。根据头部信息判断数据包类型,rtp包与rtsp包分别由onRtpPacket和onWholeRtspPacket函数处理。

RTSP处理过程中,解析出的交互命令被分发至不同的处理函数。对于rtp包处理,数据封装成rtp包后,执行onBeforeRtpSorted函数进行排序,排序后的数据放入缓存map,最终回调到RtspSession的onRtpSorted函数。这里,回调数据进入RtspMediaSourceImp成员变量,该变量指向RtspDemuxer解复用器,用于H等视频格式的解复用。

在H解复用器中,rtp包经过一系列处理后,由HRtpDecoder类的decodeRtp函数转化为H帧数据,最终通过RtpCodec::inputFrame函数分发至代理类。代理类在处理H帧数据时,分包并添加必要参数(如pps、sps信息),然后通过map对象将数据传递给多个接收者。

处理完H帧后,数据将流转至编码阶段。在RtspMediaSourceImp中,H帧数据被传递至MultiMediaSourceMuxer编码类。在编码过程中,数据通过RtspMuxer的inputFrame接口进入编码器HRtpEncoder,最后被打包成rtp包,准备分发。

总结而言,RTSP推流过程主要包含数据解析、视频解复用与编码三个关键步骤。在拉流阶段,通过鉴权成功后获取推流媒体源,利用play reader从缓存中取出rtp包并发送给客户端。

详解 WebRTC 协议原理与框架

WebRTC,全称为Web Real-Time Communication,是一个强大的实时通信API,它允许网页浏览器进行语音和视频对话,且于年由Google等公司开源并成为W3C推荐标准。WebRTC的核心在于其安全的实时传输协议(SRTP),确保数据加密、认证和完整性,实现音视频通信的可靠性。架构图展示了核心层(包括Voice Engine、Video Engine和Transport)与应用层的互动,其中Video Engine负责VP8/VP9编解码,Audio Engine处理编码、网络适配和回声消除,Transport则基于UDP协议进行高效数据传输。

WebRTC的核心功能包括音频处理(如Opus编解码、网络适配和回声消除)、视频处理(VP8/VP9编码、防抖和图像处理)、以及传输模块,它利用UDP协议提供实时、低延迟的通信。视频渲染则在应用层进行。WebRTC支持自定义开发,允许扩展API实现各种功能,如美颜、贴图等。

要使用WebRTC,开发者可以利用提供的Web API(JavaScript接口)或Native C++ API进行编程,涉及的API包括Network Stream API、RTCPeerConnection和Peer-to-peer Data API。WebRTC的架构灵活,支持P2P连接,但在NAT和防火墙环境下需要额外的ICE和STUN/TURN协议来解决连接问题。

WebRTC的协议栈涉及RTP、SETP和SCTP等协议,其中Session组件基于libjingle实现,而Transport则处理数据传输。源码结构复杂,但通过理解基本网络协议如RTP、SDP、ICE、RTCP等,可以深入学习WebRTC的实现细节。

总之,WebRTC为实时通信提供了强大的工具,开发者需要掌握基本网络协议知识,理解其架构和API,才能充分利用这一技术进行音视频应用的开发。

Miracast技术详解(四):Sink源码解析

Miracast Sink端源码最早出现在Android 4.2.2版本中,可通过android.googlesource.com查看。然而,在Android 4.3版本之后,Google移除了这部分源码,详细移除记录可在android.googlesource.com上查阅。尽管Sink端代码被移除,但Source端源码依然存在。通过使用Android手机的投射功能,仍可实现Miracast投屏发送端的功能。

为了查看源码,推荐使用Android Studio,以便利用IDE的代码提示和类/方法跳转功能。首先新建一个Native Project,将libstagefright相关源码拷贝至cpp目录,并导入必要的include头文件。在CMakeLists.txt中添加这部分源码后,同步环境,以此引用相关类与头文件,提升查看源码的效率。

Sink端核心类主要包括:WifiDisplaySink.cpp、RTPSink.cpp、TunnelRenderer.cpp。通过分析可得知,初始化操作主要在wfd.cpp中的main()方法内完成,重点关注sink->start()方法启动WifiDisplaySink,进而使用ip和端口参数执行相关操作。

RTSP通讯涉及关键步骤,包括创建RTSP TCP连接、处理连接状态与数据异步通知。当连接建立后,开始进行RTSP协商与会话建立,处理RTSP M1-M7指令。请求与响应流程需参考前面的RTSP协议分析文章,这里不详细展开。

处理RTSP消息时,首先判断消息类型,是Request还是Response。对于Request,主要处理Source端M1请求,并响应M2确认。对于Source端M3请求,处理相关属性及能力,如RTP端口号、支持的音频和视频编解码格式等。M4与M5请求则分别进行常规的响应处理。

在发送完Setup M6请求后,注册onReceiveSetupResponse()回调,用于完成RTSP最后一步,即发送PLAY M7请求。此时,Source端会按照Sink指定的UDP端口发送RTP数据包,包含音视频数据。

RTSP协商与会话建立完成后,数据流通过RTPSink处理,建立UDP连接并解析RTP数据包。在TunnelRenderer中接收并播放音视频流。流程包括消息处理、环境初始化、TS包解析、音视频裸流解码与播放等。

源码解析过程中,关键步骤包括初始化RTPSink、建立UDP连接、处理RTP与RTCP数据、解析TS包并获取音视频裸流等。移植Native Sink端难点在于隔离与处理Native相关依赖,如异步消息机制、网络连接实现等。建议在应用层实现RTSP连接、音视频解码与渲染功能,然后移植底层解析代码,以减少依赖,提高移植效率。